Caixa Ontinyent logra un beneficio neto de 9,7 millones en 2023, un 4,98% más

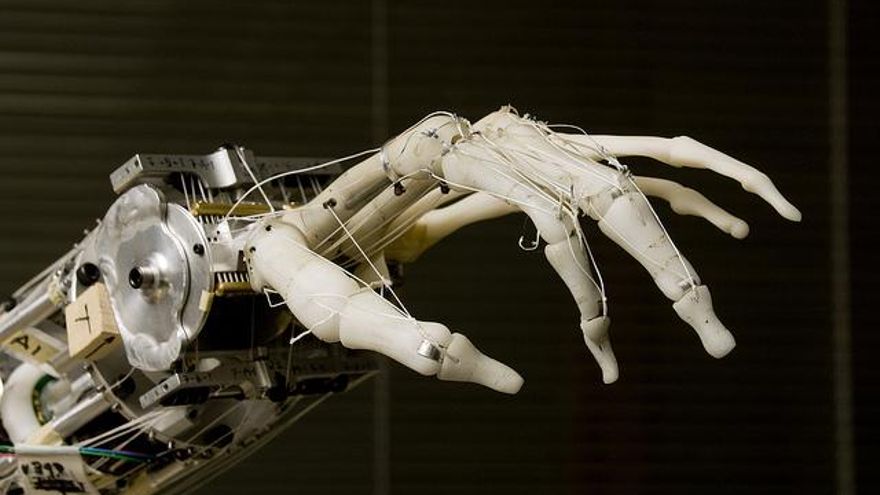

Llevamos medio siglo enseñando a los robots a ligar (y aún no han aprendido)

En 2007, los medios alertaban sobre los peligros de CyberLover, una herramienta de ‘software’ ruso que podía “imitar el flirteo en internet”. Se trataba de un bot destinado a recabar información de sus víctimas en chats fingiendo que ligaba con ellas. Sus creadores lo anunciaban como el producto definitivo para atraer a las mujeres (o a los hombres): “Ni una sola chica ha adivinado todavía que está hablando con un programa”.

No sabemos las habilidades que tenía este seductor de las redes, pero lejos de triunfar por sus dotes, el secreto de su éxito era otro. Los aficionados a los chats de entonces ni siquiera se planteaban que un ‘software’ pudiera coquetear con ellos como si tal cosa.

Aunque hoy tenemos asumido que existen falsos usuarios de Tinder, ‘chatbots’ diseñados para entretenernos en aplicaciones de mensajería, y hablamos de computación afectiva –un campo de la inteligencia artificial (IA)−, lo cierto es que los robots todavía no le han pillado el truco a eso de ligar. La práctica exige cierto nivel de inteligencia: hace falta expresar emociones e intenciones no solo mediante simple palabras, sino también con movimientos, gestos, indirectas, bromas o frases en sentido figurado. Además de saber interpretar todos estos elementos en el otro.

Un gesto vale más que mil palabras

Una buena parte del flirteo se basa en el lenguaje corporal y la modulación de la voz. En los años 60, el etólogo Iranäus Eibl-Eibesfeldt, uno de los primeros científicos en estudiar cómo ligan los humanos, analizó el comportamiento de parejas de diferentes partes del mundo e identificó una serie de patrones comunes. Hombres y mujeres solían apoyar una mano sobre la mesa, encogerse de hombros, inclinar la cabeza y sonreír.

Según Mark Stephen, presidente de Botanic, otorgarle estas habilidades a los sistemas de IA se traduce en “construir bibliotecas de comportamiento semiótico”. Stephen explica a HojaDeRouter.com que, para que un robot pueda interactuar con otros, “usamos bibliotecas básicas de palabras, gestos, tonos, ect.”.

El experto se refiere a una especie de banco de patrones de conducta que sirve a los robots para saber cómo deben actuar en cada momento. Una chica, por ejemplo, puede dar mucha información mediante gestos: “Jugar con su pelo, rozar los zapatos, mostrar las muñecas, reírse de chistes tontos, mantener el contacto visual, ladear la cabeza…”

Pero, además de estas señales corporales, hay otros gestos más sencillos que no pueden faltar −imagina que la persona con la que conversas te mirara fijamente o hiciera aspavientos sin sentido−. Por eso Sophia, el último robot androide creado por Hanson Robotics, mueve los ojos de vez en cuando, sonríe y cambia de posición. La piel que recubre su rostro femenino está fabricada con Frubber, un material flexible patentado por la propia empresa que puede ser programado para imitar el movimiento de 60 músculos diferentes de la cara y el cuello.

Por su parte, el objetivo del equipo de Botanic es “hacer robots que no son robóticos”, describe su presidente. En otras palabras, hacer la tecnología más humana. “Trabajamos con modelos de computación afectiva, de forma que emociones como palabras, sonidos e imágenes son tanto asimiladas como transmitidas por los sistemas”, indica. “Esto es lo que significa diseñar una personalidad ‘software’”.

Para que una máquina pueda coquetear, tiene que aprender a utilizar e interpretar señales de este tipo. Algo “relativamente fácil”, en opinión de Stephen: “Solo se trata de signos semióticos, algo que puede crearse artificialmente”.

Las herramientas de visión artificial y ‘deep learning’ les sirven para analizar las expresiones de su interlocutor. A partir del resultado, tanto los robots como los avatares parlantes son capaces ya de cambiar su tono de voz como respuesta.

En Botanic utilizan SSML (de Speech Synthesis Markup Language), un estándar del W3C que sirve para identificar palabras, silencios o ciertas frases en el lenguaje del asistente virtual y cambiar el énfasis y modular la voz para adecuarse a lo que quiere expresar. El equipo de Stephen no trabaja actualmente con robots, pero sí con avatares que también se mueven de acuerdo a sus palabras. “Interpretamos el significado emocional de las expresiones y determinamos cómo debe transmitirlo gestualmente”, explica Stephen.

“El sistema de IA tendría que aprender un mapa de relaciones entre los gestos [humanos] y las representaciones físicas de su significado”, indica por su parte Sam Gershman. Según este investigador en ciencias cognitivas del MIT, no hace falta enseñarles todas las posibilidades, sino solo aquellos signos que necesitan interpretar. Una forma de hacerlo, dice el experto, es construir un modelo generativo que describa qué tipo de gestos acompañan a los diferentes mensajes. Aplicándolo después a la inversa, sería posible inferir el significado de cada señal.

Poco sentido del humor

Tanto Siri como Cortana, los asistentes virtuales de Apple y Microsoft, saben contar chistes –la segunda incluso imita a Chiquito de la Calzada y Gila−; sin embargo, el sentido del humor y la perspicacia no son los puntos fuertes de los sistemas inteligentes. Quizá puedan contar un chascarrillo programado, pero les cuesta entender y utilizar frases irónicas o con sentido figurado.

“Algunos pueden predecir si una broma es graciosa o no e identificar cierto tipo de metáforas en el lenguaje”, indica Gershman. Sin embargo, el investigador del MIT está seguro de que actualmente no existe ningún robot que comprenda perfectamente la comunicación no literal. La razón, señala, es que un entendimiento semejante al humano requiere un modelo muy rico del mundo. “No sabemos cómo darles a los sistemas de IA una idea del mundo siquiera del nivel de la que tiene un niño”, explica Gershman.

Interpretar una frase sarcástica, una metáfora o sobreentender el significado de una expresión “depende de unas nociones culturales muy amplias que tendríamos que guardar en una especie de base de datos de conocimiento”, explica José Luis Salmerón, director del Data Science Lab de la Universidad Pablo de Olavide (Sevilla). Algo que, según el investigador, podría solventarse cuando las máquinas no solo obtengan información de su propio almacén, sino que puedan acudir a internet para recabarla.

Esta es el objetivo que persiguen los ingenieros de Google: desarrollan redes neuronales artificiales y otros modelos de ‘deep learning’ para que un sistema artificial pueda sumergirse en la Red y aprender de la ingente cantidad de expresiones que circulan por el ciberespacio. Estos expertos pueden utilizar toda esta información para enseñar a las máquinas, mediante modelos numéricos, cómo combinar las palabras.

De todos modos, Stephen defiende que ni siquiera los humanos interpretamos bien todos los gestos y palabras. No conocemos expresiones o símbolos de otros países e, incluso utilizando un mismo lenguaje, se producen muchos malentendidos (por no mencionar los problemas de comunicación propios de aplicaciones como WhatsApp).

Enseñar a las máquinas a ser empáticas, afectivas, a interpretar emociones y responder acordemente puede ser útil en campos como la robótica asistencial. Pero, ¿realmente querríamos que un robot ligara con los humanos sin que notáramos la diferencia?

“Suena inquietante que una máquina pueda llegar a manipularte”, admite Salmerón. Y Stephen advierte que, si fuera posible, “a muchas empresas les gustaría tener ese poder”. Por suerte o por desgracia, los robots todavía no han aprendido (y quizá no lo hagan nunca) a tirarnos los trastos.

---------------------------------------------------------------------------------------------------------------

Las imágenes de este artículo son propiedad, por orden de aparición, de Daniel Lombraña González, Universidad de Washington y Bhupinder Nayyar