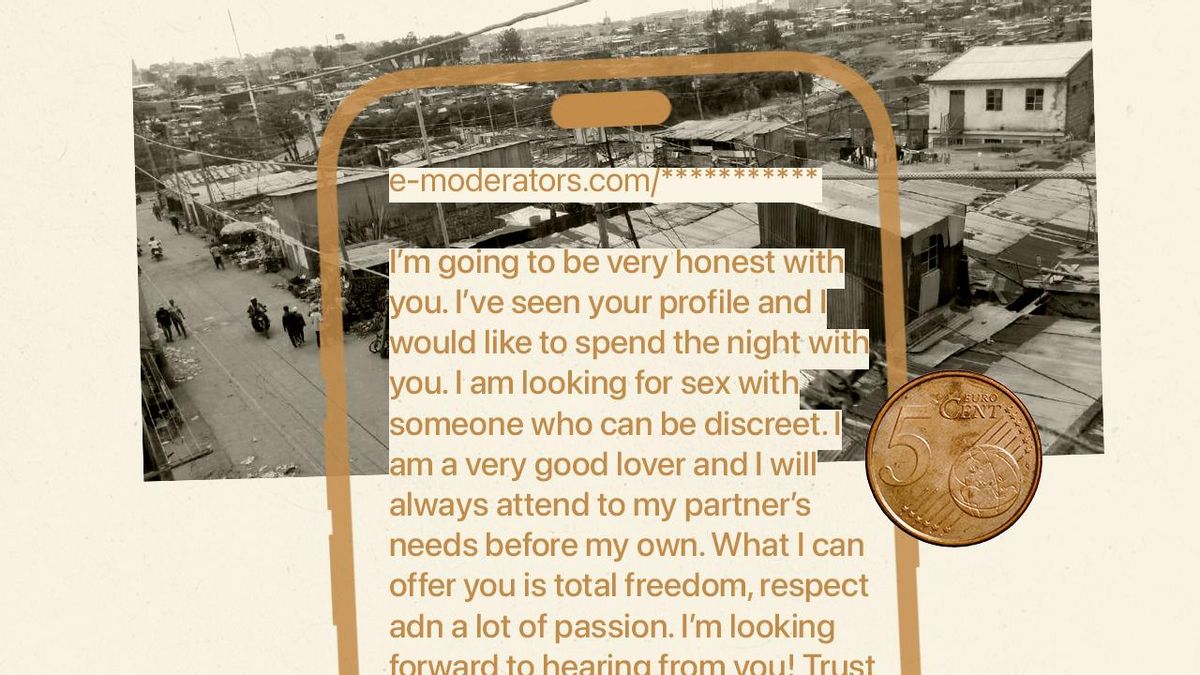

La oscura realidad de los chats sexuales con la IA: personas en Kenia o Venezuela que cobran 5 céntimos por mensaje

Uno de los trabajos más desconocidos del mundo digital es el de la moderación de plataformas. Son todas aquellas personas que apartan del contenido público aquello que no debe verse, como mutilaciones, autolesiones o todo tipo de abusos. Sin embargo, existe una categoría aún más oscura que la industria digital encuadran en la categoría de “moderación”: la suplantación de cuentas en las aplicaciones de citas y páginas de contactos.

“Cuando iniciaba sesión en mi panel de trabajo, tenía acceso a múltiples perfiles falsos de varios géneros; normalmente de tres a cinco personajes diferentes que podía manejar simultáneamente. A veces tenía que operar personajes masculinos y femeninos en el mismo día, dependiendo de lo que los usuarios de la plataforma estuvieran buscando”, relata Michael Geoffrey Asia, un trabajador que desempeñó este trabajo en Nairobi.

“Existe una idea equivocada sobre este trabajo”, coincide Oskarina Verónica Fuentes, que lleva una década realizándolo desde Venezuela y Colombia. “La gente piensa que es fácil porque trabajamos desde casa, frente a la computadora. Algunos también creen que ganamos mucho dinero y que tenemos beneficios adicionales por trabajar para grandes empresas tecnológicas. Otros no tienen idea de que el entrenamiento de la IA se hace de esta manera y no en una oficina con un equipo tecnológico extraordinario”, añade.

Ambos testimonios han sido recogidos por el proyecto Data Workers, que anima a estos trabajadores clave para la sociedad digital a que expongan la realidad de su sector, se alíen y peleen por sus derechos laborales. Desde 2022 han participado más de una veintena de ellos, desde Alemania hasta Kenia, y desde Brasil hasta Siria. Sin embargo, el último de ellos, enviado por Michael Geoffrey Asia, ha añadido una capa más de profundidad a lo que sabemos sobre la “moderación”.

En la era de la IA, estos trabajadores ya no solo intervienen para “afinar” un modelo, evaluando la calidad de texto, imágenes y vídeos que genera. También se hacen pasar por ella por 5 céntimos cada respuesta, escribiendo al menos 40 palabras por minuto.

Siempre sospeché que algunas de las personas al otro lado del chat pensaban que yo era un compañero de IA. A veces me preguntaban si era real, o me ponían a prueba con preguntas que parecían diseñadas para atrapar a un bot

“Siempre sospeché que algunas de las personas al otro lado del chat pensaban que yo era un compañero de IA. A veces me preguntaban si era real, o me ponían a prueba con preguntas que parecían diseñadas para atrapar a un bot. Cuando más tarde leí sobre este tipo de 'parejas' de IA, me di cuenta: la empresa probablemente me estaba usando para entrenar estos sistemas. Cada conversación que tenía, cada respuesta que redactaba, cada forma en que aprendía a mantener a los usuarios interesados”, desvela Asia.

En estas plataformas, la inteligencia artificial suele encargarse de las tareas de recolección de datos y de las respuestas más genéricas, mientras que los humanos aportan la “sensación de humanidad” que los algoritmos aún no pueden replicar con éxito. El trabajador se encarga de gestionar emociones como la empatía, el humor o las interacciones sexuales, mediante un sistema diseñado para ocultar esta suplantación digital.

“Estaba entrenando a mi propio reemplazo, enseñando a las máquinas cómo manipular a personas solitarias de la misma manera que a mí me obligaban a hacerlo”, continúa el trabajador.

Una estafa doble

La realidad de los trabajadores precarios que están detrás de muchos de los sistemas que en Occidente pasan por “automáticos” es otra de las caras ocultas del sector. “Este tipo de simulación o personificación no es nuevo, sino que es una constante en la industria de la IA. Casos de compañías de tecnología que usan trabajadores precarizados remotos para simular una IA que en realidad no existe se vienen registrando desde hace años” recuerda Milagros Miceli. “Pero el caso de los chats sexuales es especialmente penoso”.

Este tipo de simulación o personificación no es nuevo, sino que es una constante en la industria de la IA. Pero el caso de los chats sexuales es especialmente penoso

Miceli es socióloga y doctora en ciencias de la computación. Es una de las investigadoras más reputadas sobre las asimetrías de poder y explotación que rodean a los trabajadores de la industria de la IA y ha sido incluida este 2025 por la revista Time en la lista de las 100 personas más influyentes sobre esta tecnología. La experta, coordinadora del proyecto Data Workers, destaca cómo este tipo de suplantaciones son humillantes para las dos partes.

“Para el usuario porque la estafa en este caso implica el hecho de que un trabajador de carne y hueso— y no un algoritmo sin discernimiento e incapaz de juzgar— es quien está detrás de las pantallas. Y para ese trabajador, este tipo de simulación implica, además de la presión, la incertidumbre y la mala paga tan comunes en el trabajo de datos, una disociación de la identidad y de las preferencias sexuales que en muchos casos, como el de Michael, se vive con mucha culpa y vergüenza”, detalla en conversación con elDiario.es.

Opacidad

¿Qué tipo de servicios promocionan sus chats íntimos con la IA para luego contratar a personal humano para mejorar la apariencia del robot? ¿Son acaso las 'novias de IA' que publicitan algunas empresas fruto de ese doble engaño? Es complicado penetrar en un sector opaco por naturaleza. Michael Geoffrey Asia desconocía qué plataformas podrían estar contratando sus servicios, ya que él trabajaba para una subcontrata especializada en poner en contacto a personas de zonas necesitadas con compañías digitales que requieran de sus servicios.

Karen Hao, autora de El imperio de la IA, lo denomina “capitalismo de desastre” por la tendencia de estas subcontratas de establecerse en zonas donde ha sucedido una catástrofe social o medioambiental. “Son plataformas que tratan de buscar la mano de obra más barata en el mercado global. Se dieron cuenta es que la mejor manera de encontrarla es ir a los lugares más pobres y desesperados del mundo”, explicaba en una entrevista reciente con elDiario.es.

“Inicialmente, eso fue Venezuela, donde la economía estaba en un estado desastroso, pero la población también estaba altamente educada y tenía alta conectividad. A medida que la economía de Venezuela comenzó a recuperarse ligeramente, el trabajo se trasladó a otros lugares más desfavorecidos durante la pandemia, cuando otros países estaban cayendo en picado, como Kenia”, detallaba.

El contrato de confidencialidad no solo protegía el modelo de negocio de la empresa; nos aislaba, impidiéndonos buscar apoyo o incluso explicar a nuestras familias lo que realmente hacíamos por dinero

Asia sí señala directamente a la plataforma que lo captó a él. Es New Media Services, que se promociona como un servicio “donde la automatización se fusiona con la experiencia humana”. elDiario.es ha tratado de contactar durante varias semanas con New Media Services, sin obtener respuesta a los requerimientos.

Este no es un fenómeno marginal, sino una industria masiva que se extiende por todo el Sur Global como parte de este trabajo fantasma. Se estima que millones de personas sostienen la economía digital desde países con bajos costes laborales como Kenia, Filipinas o diversos puntos de Latinoamérica.

El trabajador también señala otras dos empresas con más peso en el sector de la moderación y el entrenamiento de IA. Son Cloudworkers y EnterTalkPro, que opera varias plataformas de este tipo alrededor del mundo. Ninguna de las dos ha contestado a las preguntas de este medio.

Es una negativa que coincide con los acuerdos de confidencialidad que hacen firmar a sus empleados, que les impide revelar las características de su labor incluso a su familia y amigos. “El acuerdo de confidencialidad de la empresa exigía que no pudiera decirles la verdad. Era obligatorio. Tenías que aceptar el acuerdo para continuar con el proceso de solicitud del empleo”, desvela.

Ese contrato fue otra de las losas que terminaron cayendo sobre su salud mental. “Lo que inicialmente parecía una protección de privacidad estándar se convirtió en una herramienta de silencio y control. No podía revelar la naturaleza del trabajo, las identidades falsas, el contenido sexual o el costo psicológico. El contrato de confidencialidad no solo protegía el modelo de negocio de la empresa; nos aislaba, impidiéndonos buscar apoyo o incluso explicar a nuestras familias lo que realmente hacíamos por dinero”.

Sin derechos

El proyecto Data Workers aspira tanto a aportar luz sobre las facetas escondidas de la industria de la IA como a dignificar la labor de los trabajadores que lo hacen posible. Está auspiciado por el DAIR Institute, fundado por la investigadora Timnit Gebru, co-líder del equipo de IA ética de Google hasta 2020, cuando salió de la empresa tras un conflicto por un artículo crítico sobre esta tecnología (costes ambientales, opacidad, sesgos y concentración de poder).

La reivindicación de Michael Geoffrey Asia es que los daños de este trabajo sean reconocidos. “¿Era real la explotación de la intimidad con fines de lucro? Sí. No nos pagaban solo por los mensajes, sino por la ilusión, convirtiendo nuestras emociones en ingresos”, denuncia. “El pago estaba ligado a la producción: 0,05 dólares por mensaje, cada uno debiendo cumplir con un recuento de caracteres requerido. Para mantener el ritmo, teníamos que escribir al menos 40 palabras por minuto”.

El futuro de la IA debe construirse sobre algo más que nuestra humanidad rota. Hasta entonces, recuerden que una novia de IA que responde a su soledad podría ser simplemente un hombre en un barrio marginal de Nairobi

En Kenia, el salario mínimo ronda los 110 euros mensuales, una cifra que Michael no alcanzaba a pesar de gestionar miles de interacciones desde los suburbios de Nairobi, donde relata que ni siquiera podía pagar su alquiler de forma puntual. En otros lugares como Venezuela, los ingresos por estas tareas pueden ser superiores al salario base oficial, pero no sacan al trabajador de la precariedad ni le permiten esquivar la dependencia de estas plataformas, que no ofrecen seguridad social o contrato estable.

“Lo que me sucedió a mí, y a miles de otros que realizan este trabajo invisible, no fue solo explotación. Fue un borrado sistemático de nuestra humanidad al servicio de la construcción de las mismas tecnologías que nos reemplazarían”, explica Asia. “Fuimos utilizados para enseñar a las máquinas cómo imitar la intimidad, cómo explotar la soledad, cómo sonar humanos permaneciendo completamente vacíos”.

El antiguo moderador, que ahora es secretario general de la Asociación de Etiquetadores de Datos, exige “que los sistemas de IA sean evaluados por sus consecuencias psicológicas, emocionales y sociales antes de su implementación, no después de que el daño esté hecho”. También pide que “la comunidad de trabajadores” pueda participar en las decisiones “sobre cómo se construye, desarrolla, implementa y regula la IA”.

El vacío legal en torno a estas prácticas es enorme. En la Unión Europea, la reciente Ley de IA obliga a que los sistemas identifiquen claramente cuando un usuario está interactuando con una máquina, pero su aplicación aún es incipiente y no contempla el caso específico de humanos haciéndose pasar por IA. En EEUU el vacío es aún mayor después del veto de Donald Trump a que los estados puedan regular la IA y su negativa a establecer reglas nacionales.

El problema se agrava además porque estas empresas operan desde múltiples jurisdicciones: la plataforma puede estar registrada en un país, los trabajadores en otro, y los usuarios en un tercero, creando un limbo legal que las protege de responsabilidades. “Esto no se trata solo de mejores condiciones de trabajo. Se trata de reconocer que no se puede construir una IA ética sobre la base de mano de obra humana explotada y traumatizada”, enfatiza Asia. “Si los datos de entrenamiento provienen de personas que fueron destruidas psicológicamente en el proceso de crearlos, entonces la tecnología en sí misma está contaminada desde el principio”.

Es un aspecto en el que se une con otras trabajadoras de datos y etiquetadoras, como Oskarina Verónica Fuentes. “Desde la distancia, servimos con dedicación para mejorar la inteligencia artificial y hacerla más accesible cada día”, recuerda. Pero “somos fantasmas para la sociedad y me atrevo a decir que somos mano de obra barata y desechable para las empresas a las que hemos servido durante años sin garantías ni protección”.

“Nos merecemos algo mejor. Los usuarios engañados se merecen algo mejor”, concluye Michael Geoffrey Asia: “Y el futuro de la IA debe construirse sobre algo más que nuestra humanidad rota. Hasta entonces, recuerden que una novia de IA que responde a su soledad podría ser simplemente un hombre en un barrio marginal de Nairobi, preguntándose si alguna vez volverá a sentir amor real”.

11