Cómo diferenciar a Mozart de Nirvana gracias a la teoría de la información

La identificación y clasificación automática de géneros musicales es uno de los problemas clásicos de la computación. Que una máquina sea capaz de diferenciar una pieza de jazz, de una de heavy metal nunca ha resultado sencillo, entre otras cosas, porque los propios géneros musicales no obedecen tanto a las propiedades de la música en sí, como a las circunstancias sociales y culturales en las que se han desarrollado. Sin embargo, un equipo de investigadores acaba de publicar un método, basado en la teoría de la información, que supone un nuevo paso para resolver este problema.

La teoría de la información es una propuesta teórica que analiza la transmisión de información a través de sus propiedades matemáticas. Si pensamos en la música como una forma de comunicación, no es descabellado pensar que se puede aplicar esta teoría para estudiarla y caracterizarla. El problema es que resulta difícil traducir la complejidad de la música a una secuencia de parámetros que se puedan estudiar mediante esta teoría.

Buscando patrones ocultos

Sin embargo, los investigadores Gerardo Febres y Klaus Jaffé, de la Universidad Simón Bolívar (Venezuela), han abordado el problema de una forma novedosa. En lugar de analizar la música en sí, han trabajado con los archivos MIDI, un formato muy utilizado en el mundo de la música. Este tipo de archivos se puede abrir con un editor de texto, mostrando una secuencia de letras y símbolos que, aparentemente, carecen de sentido. Pero, aunque a simple vista no encontremos patrones en esas secuencias de caracteres, “esos patrones están ahí y constituyen el lenguaje con el que cada pieza musical se ha codificado”, ha explicado Febres a eldiario.es.

Sin embargo, no todos los caracteres tienen la misma cantidad información, así que el primer objetivo era encontrar, dentro del mensaje, “dónde reside la información y dónde los símbolos empleados constituyen básicamente ruido”, explica Febres. De esta forma los investigadores podían reducir el número de símbolos al mínimo necesario para seguir obteniendo la música original. A este grupo de símbolos se le denomina conjunto de mínima entropía. Siendo la entropía la cantidad de información promedio que tiene cada uno de los símbolos utilizados.

Pero el proceso para llegar a este punto es relativamente lento, ya que para la identificación de patrones el algoritmo debe recorrer un número de combinaciones enorme y encontrar el conjunto mínimo de símbolos que constituyen una pieza “puede llevar varios días de operación del computador”, con lo que los investigadores trabajan en contra formas que les permitan bajar los tiempos operativos “a valores más razonables”, asegura Febres.

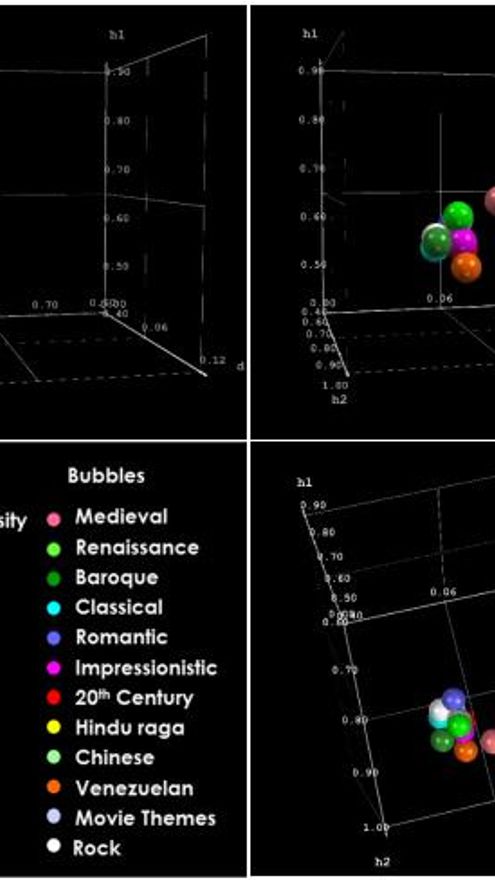

Un vez hecho esto, Febres y Jaffé analizaron las variaciones que existían entre 450 piezas musicales de 71 compositores y 15 épocas diferentes y se dieron cuenta de que se podían establecer diferencias entre los distintos géneros musicales. “Hemos podido identificar que la entropía de la música sigue una tendencia general de cambio, desde sus valores típicos para la música medieval, hasta los del siglo XX”, asegura Febres.

Sin embargo, pese a los buenos resultados obtenido por estos investigadores, el algoritmo aún tiene sus limitaciones. “La música es un lenguaje complejísimo”, afirma Febres, y “reconocer, sin espacio para la equivocación, entre un género musical y otro, es por ahora una meta distante”.

Aún así, los autores del estudio, publicado en arXiv (sin revisión por pares), afirman que “estas técnicas de clasificación prometen ser útiles en otras disciplinas para el reconocimiento de patrones”. Y Febres asegura que también están estudiando las posibilidades de aplicar estos mismos principios “al estudio de la información contenida en mensajes de dos dimensiones, como por ejemplo, fotografías”.