La gran pregunta de la burbuja de la IA (y la economía global) para 2026: ¿cuándo caduca un chip?

Hay un viejo aforismo en Silicon Valley que dice que cuando una empresa tecnológica empieza a insistir demasiado en lo que no es y en lo que no hace, es justo el momento de preocuparse por lo que realmente es y lo que realmente hace. Este final de año ha estado marcado por ese runrún en la empresa más valiosa del mundo, el pilar que sostiene todo el discurso económico en torno a la inteligencia artificial.

Nvidia, valorada hoy en unos 4,5 billones de dólares tras alcanzar los 5 billones a finales de octubre, se ha visto obligada a enviar un memorando a sus empleados explicando con detalle por qué la compañía no es la próxima Enron ni la siguiente Lucent Technologies. Son palabras mayores: Enron fue un gigante energético estadounidense que quebró en 2001 tras destaparse un fraude contable masivo; mientras que Lucent lideró el despliegue de infraestructura digital en la burbuja de las puntocom para irse a pique en cuanto explotó, convertida en el máximo exponente de la sobrevaloración y expectativas infladas de aquel período.

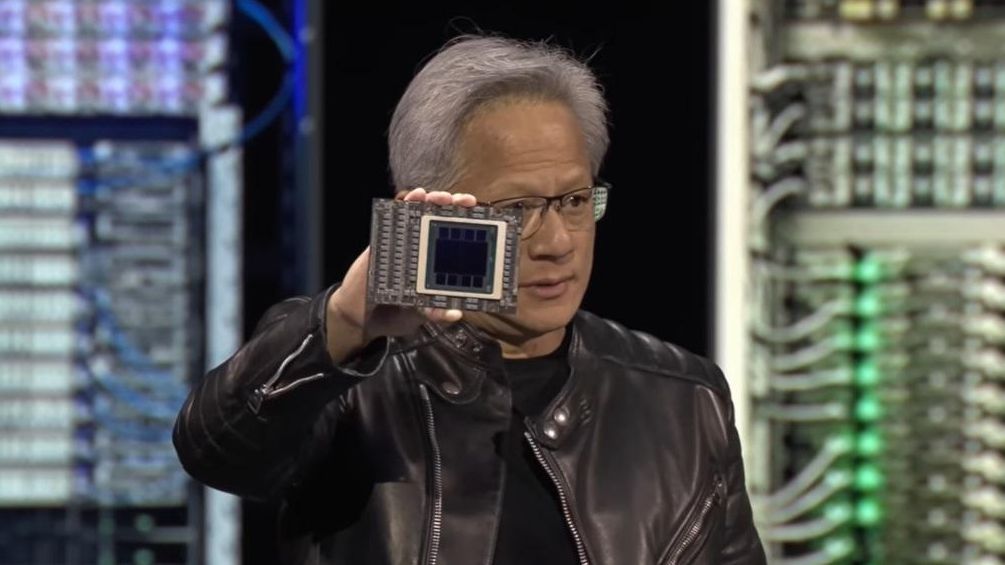

La compañía dirigida por Jensen Huang expone en la comunicación que “no se parece a los fraudes contables históricos porque el negocio subyacente de Nvidia es económicamente sólido, nuestros informes son completos y transparentes, y nos preocupamos por nuestra reputación de integridad”.

El propio Huang se ha mostrado frustrado por el hecho de que su empresa sea vista como una bomba a punto de explotar pese a sus excepcionales resultados económicos. “Si hubiésemos tenido un mal trimestre, sería una prueba de que existe una burbuja de la IA. Si hemos tenido un gran trimestre, estamos alimentando la burbuja de IA”, dijo en una reunión con inversores tras la presentación de sus cuentas, en las que presentó un beneficio neto de 31.910 millones de dólares, un 65% más interanual, superando las predicciones de los analistas.

La inversión circular y el reloj

Los recelos en torno a la empresa tienen varios focos. El principal es la temida “inversión circular”. En este sentido, sus críticos señalan el gran número de operaciones en las que Nvidia ha invertido en empresas de IA, inyectándoles liquidez para que puedan comprar más chips producidos por Nvidia.

Se trata de acuerdos como el ratificado con OpenAI, por el que se ha comprometido a invertir hasta 100.000 millones de dólares en la desarrolladora de ChatGPT, con el objetivo de que gaste esos fondos en sus productos. Junto a Microsoft, ha comprado una parte de Anthropic (referencia en el sector de los chatbots junto a OpenAI y Google) valorada en 15.000 millones de dólares. A cambio, Anthropic arrendará 30.000 millones en capacidad de computación a Microsoft, que estará basada en chips producidos por los de Huang.

Es fácil encontrar capital de Nvidia en cualquier proyecto relacionado con IA. En Nokia, por ejemplo, que quiere adaptar la infraestructura de telecomunicaciones a las necesidades de esta tecnología, ha comprado una participación del 2,9%, equivalente a 1.000 millones de dólares. Una liquidez que la empresa finlandesa usará para adquirir sus chips e instalarlos en los centros de control de sus antenas.

Según los datos de Pitchbook, Nvidia ha hecho más de 70 inversiones de este tipo solo en 2025. La preocupación en torno a ellas es un eco de la burbuja de las puntocom, cuando empresas como Lucent se endeudaron para invertir en otras compañías y que estas comprasen sus productos.

La diferencia clave 25 años después es que Nvidia no se está endeudando para cerrar estas operaciones. Está utilizando el flujo de caja derivado de sus grandes resultados. Por lo tanto, la evolución de sus beneficios “no depende de los acuerdos de financiación de los proveedores para aumentar sus ingresos”, sostiene en el memorando interno.

Con fecha de caducidad

Sin embargo, estos movimientos de Nvidia para apoyar a actores no consolidados no es el único foco de suspicacias. Tampoco las valoraciones disparadas de empresas sin beneficios, como OpenAI. La preocupación que se extiende en las últimas semanas entre analistas y empresarios es la cuantía de la inversión necesaria para desplegar productos que no han mostrado rentabilidad. Los chips de Nvidia son extremadamente costosos y llenar un centro de datos con ellos cuesta decenas de miles de millones, pero las empresas que lo están haciendo aún no ven retornos claros.

El problema es que no disponen de mucho tiempo para encontrarlos. Los cálculos de la industria son que esos chips tan caros podrían depreciarse completamente en unos “cinco años”, ha avisado Arvind Krishna, director ejecutivo de IBM, en una reciente entrevista. Esto se debe a que los procesos de entrenamiento y ejecución de la IA son mucho más intensivos y provocan “una tasa de fallos muy alta” en estos componentes. Pero también porque en ese lustro los “semiconductores serán 100 veces mejores”, por lo tanto, una compañía que siga utilizando modelos antiguos se verá muy por detrás de la competencia.

En mi opinión, no hay forma de que se obtenga un rendimiento de eso, porque 8 billones de gastos operativos significan que se necesitan aproximadamente 800.000 millones de beneficios solo para pagar los intereses

“Según los costes actuales, se necesitan unos 80.000 millones de dólares para llenar un centro de datos de un gigavatio”, revela Krishna. “Analicémoslo. Estás construyendo un centro de datos físico mucho más grande. El hormigón y el acero resistirán. Igual que la central eléctrica que hay junto a él”, detalla sobre los gastos. Pero, con los chips, “hay que aprovecharlo todo en cinco años, porque en ese momento hay que desecharlo y rellenarlo de nuevo”.

El sector de la IA, impulsado por las grandes tecnológicas, ha hecho anuncios para construir centros de datos de unos “100 GW” en total, prosigue el responsable de IBM, al que le salen las cuentas. “Eso son 8 billones de gastos operativos. En mi opinión, no hay forma de que se obtenga un rendimiento de eso, porque 8 billones de gastos operativos significan que se necesitan aproximadamente 800.000 millones de beneficios solo para pagar los intereses”.

Pero si esa depreciación se acelera, las grandes tecnológicas no solo habrán sobreinvertido: habrán repartido el coste de sus activos durante más tiempo del que estos generan valor. Eso implica beneficios artificialmente inflados y un ajuste que no llegará por la falta demanda, sino por el descuadre de los balances.

Trampa contable “en el corazón de la IA”

Los cinco años que calcula Krishna se sitúan el rango optimista que maneja la industria para desechar los chips. Esa cuenta, no obstante, no tiene en cuenta que el entrenamiento de una inteligencia artificial es un proceso tan demandante en términos de computación y energía que estos componentes podrían decaer en rendimiento a partir de los 12 o 18 meses.

En ese momento no quedarían inservibles, pero deberían ser relegados a tareas menos intensivas, ya que los chips empezarán a costar más en energía consumida que el beneficio que generan en computación.

“Aquí está el enigma: los chips que están en el corazón del despliegue de infraestructuras tienen una vida útil de entre uno y tres años, debido a la rápida obsolescencia tecnológica y al desgaste físico, pero las empresas están calculando una amortización a lo largo de cinco o seis años. En otras palabras, reparten el coste de sus enormes inversiones de capital durante un periodo más largo del que justifican los hechos”, expone Mihir Kshirsagar, director del Technology Policy Clinic de la Universidad de Princeton.

Esta situación no es un secreto en la industria. The Economist lo denominó ya en septiembre “El rompecabezas contable de 4 billones de dólares en el corazón de la nube de IA”. Después fue Michael Burry, el inversor que se hizo famoso por predecir la crisis de 2008 (interpretado por Christian Bale en la película La Gran Apuesta), que calcula que las grandes tecnológicas que gestionan centros de datos masivos están subestimando la depreciación de sus chips en 176.000 millones de dólares para el periodo 2026-2028.

“Subestimar la depreciación extendiendo la vida útil de los activos aumenta artificialmente las ganancias: uno de los fraudes más comunes de la era moderna”, acusó Burry. Otros análisis, como el de la consultora Bain & Company, cifran este desfase en 800.000 millones de dólares para 2030.

Esta brecha entre gastos y resultados podría cobrar una importancia aún mayor a partir de 2026, año en el que la mayoría de consultoras y analistas apuntan como el momento de inflexión en el que las compañías empezarán a buscar retornos en sus inversiones en IA generativa. Los avances “siguen impresionando, pero llevarlos más allá de pilotos y pruebas requiere un trabajo que suele considerarse menos atractivo, como la limpieza de datos, la integración en los flujos de trabajo existentes, la gobernanza, nuevos modelos de precios y el cumplimiento regulatorio”, destaca, por ejemplo, Deloitte.

El “valor en cascada”

Nvidia también ha contestado a estas dudas en su citado memorando. Asegura que sus chips “se amortizan a lo largo de un periodo de entre cuatro y seis años, en función de su durabilidad real y de los patrones de uso”. Los “más antiguos, como los A100 (lanzados en 2020), siguen funcionando con altos niveles de utilización y generando sólidos márgenes de contribución, manteniendo un valor económico significativo mucho más allá de los dos o tres años que sostienen algunos analistas”.

Los chips más antiguos, como los A100 (lanzados en 2020), siguen funcionando con altos niveles de utilización y generando sólidos márgenes de contribución, manteniendo un valor económico significativo mucho más allá de los dos o tres años que sostienen algunos analistas

La compañía detalla que sus chips tienen un “valor en cascada”, ya que después de ese rendimiento máximo inicial destinado al entrenamiento de IA, pueden realizar otras labores menos exigentes que seguirán siendo valiosas para determinadas empresas.

“Este parece ser el mejor argumento de la industria. Y la lógica es sólida en principio”, reconoce el profesor Mihir Kshirsagar, aunque señala que tiene condicionantes. El primero, que ese grupo de compradores de chips de segunda mano debe ser lo suficientemente grande como para absorber el gran volumen que podrían poner a la venta los gigantes tecnológicos. Y el segundo, que la propia Nvidia no ahogue ese mercado con ofertas más atractivas.

Esa contradicción existe en el discurso de Nvidia. En marzo de 2025, el propio Jensen Huang advirtió que cuando los Blackwell (sus chips último modelo) llegaran al mercado, “no podrías regalar los Hopper” (los chips lanzados dos años antes). Aunque Huang bromeaba, el punto es justo en el que se concentran todas las dudas: si cada nueva generación de Nvidia reduce drásticamente el valor de la anterior, el período de depreciación de cinco años que las tecnológicas están reflejando en sus balances podría ser difícilmente sostenible.

Por último, también existe la posibilidad de que un nuevo actor irrumpa en el mercado y proponga chips que rivalicen con los de Nvidia a un precio más competitivo. Google, por ejemplo, acaba de presentar un producto que podría llegar a hacerlo. “Estamos encantados con el éxito de Google: han logrado grandes avances”, tuiteó Nvidia, que sin embargo asegura “estar una generación por delante”.

Poner todos estos factores en conjunto sugiere que confiar en un mercado secundario robusto de chips es ilusorio

“Poner todos estos factores en conjunto sugiere que confiar en un mercado secundario robusto de chips es ilusorio”, incide Kshirsagar. “Nada de esto implica que los chips antiguos se vuelvan inútiles: encontrarán compradores. Pero lo harán a precios que no sostienen las hipótesis de una vida útil de cinco o seis años”, avisa el experto. “La brecha entre la amortización contable y la amortización económica” sigue existiendo, aún con ese “mercado secundario”.

La vida útil de los chips y, por tanto, de las inversiones masivas en centros de datos que se han visto desde 2023 ha sido uno de los grandes debates en la industria de la IA en las últimas semanas. Muchas de las preguntas que plantea empezarán a resolverse en 2026, cuando algunas de esas instalaciones se acerquen ya al límite de rendimiento que expresan los analistas. ¿Se convertirán esos chips en carísimos pisapapeles, o tendrán salida como computación de segunda mano?

Si Nvidia tiene razón y sus chips mantienen valor durante al menos un lustro, la industria habrá sorteado el primer gran bache de la revolución de la IA. Si no es así, los agujeros contables anunciados por inversores como Burry empezarán a aparecer en los balances de las grandes tecnológicas, el negocio y la cotización de Nvidia se resentirán y el shock podría extenderse por toda la economía. La cuenta atrás para obtener la respuesta ya está en marcha.

6